La analítica del aprendizaje me interesa desde la perspectiva de quien aprende, o mejor dicho quienes aprenden, puesto que aprendemos, sobre todo, a través de la interacción y la experiencia. La otra perspectiva es la de las organizaciones, en línea con la analítica académica, también útil, que ahora me interesa menos.

Hablando de casos y ejemplos concretos de medir el aprendizaje, me encuentro con el enfoque centrado en el análisis de discurso, basado en el supuesto de que un indicador clave del aprendizaje, de la generación de significado, es la calidad de contribución al discurso.

Este enfoque concreto de análisis del discurso en busca de claves e indicadores de aprendizaje se inspira, por un lado, en cómo los científicos construyen argumentos y defienden su postura en un debate.

Tenemos, por otro lado, la teoría de la argumentación y la retórica que data de los filósofos griegos, y cuya articulación reciente en esquemas de argumentación tuvo una adaptación enfocada en modelos computacionales.

Otras fuentes de inspiración son los sistemas de información basados en asuntos y su traducción a un modelo hipertextual de datos, que posibilita la visualización de conversaciones.

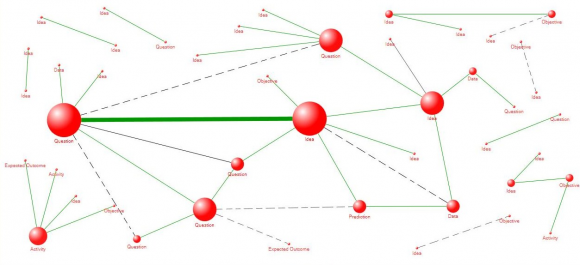

Como resultado, tenemos un método de análisis en el que los nodos son las personas, pero también lo son las ideas. Cada post en un blog sería, por ejemplo, un nodo. A partir de ahí, se trata de establecer enlaces de distinto valor argumentativo y retórico entre nodos-idea (trabajando con una tipología de ideas y de enlaces), asociados a nodos-persona.

Algunos de los tipos de información que se pueden obtener de ese modo son mapas de ideas y de conceptos, actitudes de las personas o la centralidad de los nodos. (Al margen de su utilidad para mejorar el aprendizaje, se me ocurre como posible método para analizar fenómenos como la polarización de grupo).

La analítica del aprendizaje enfocada al discurso en principio debe permitir reflexiones más profundas que el análisis cuantitativo de actividades de «más bajo nivel» (número de logs para descargar un recurso, duración de las sesiones, número de comentarios, etc). Esta mayor profundidad se debe al hecho de que se recogen datos explícitos sobre el contexto cognitivo de la persona (movimiento retórico que quiere realizar con un comentario, significado que atribuye a una relación, etc.).

Disponer de este tipo de datos implica que las personas los generen, como una capa de información adicional encima de lo que hacen en la web. Se trata, por tanto, de una analítica activa, con la colaboración de las personas que aprenden, frente a métodos pasivos de «tú vas aprendiendo y yo te analizo». Un método muy vinculado al autoconocimiento como base del aprendizaje continuo.

Una herramienta libre experimental inspirado en este método es Cohere. Es un espacio personal de trabajo que permite el registro de los datos cualitativos necesarios. Me gustará probarla para hacerme una idea de qué costes, en forma de tiempo y de cambio de comportamiento, implica en el día a día en la Red, a cambio de qué beneficios. De entrada, categorizar sistemáticamente las propias contribuciones y las relaciones entre contenidos parece un esfuerzo de reflexión adicional importante (parecido, por cierto, al de la curación de contenidos). Prestaré atención también a cuestiones de compatibilidad y del uso de RSS, claves para el diseño de cualquier herramienta libre que quiera encontrar aceptación.