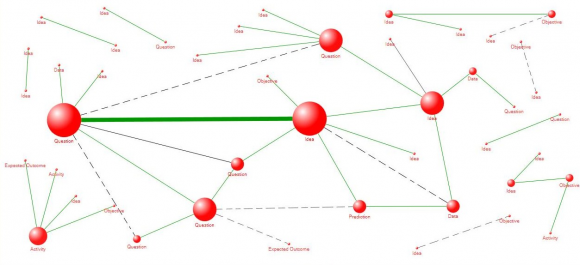

La educación personalizada es uno de los grandes temas en educación hoy en día y, debido a su componente tecnológico, el foco de muchas empresas tecnológicas de nueva creación (un ejemplo que comenté hace un año en este blog es Knewton). Es una aplicación de la tecnología realmente prometedora pero que entraña un asunto delicado, que era uno de los temas estrella ya en LAK12, MOOC sobre analítica del aprendizaje en que participé el año pasado: la propiedad de los datos y el peligro de dejar a la persona fuera del bucle de realimentación de un sistema que, se supone, le apoya en su aprendizaje.

Audrey Watters comparte en su blog una charla suya que versa sobre la propiedad de los datos educativos, que demuestra que el tema no deja de perder actualidad. Buscando escenarios positivos, Audrey proyecta un posible futuro al estilo del yo cuantificado (o automonitorización) en educación. Un yo cuantificado con actitud de propietario, claro.

A “quantified self” movement within education implies personal ownership and certainly demands personal control over data. As such, it requires setting personal goals. It requires a personal definition of “learning.”

El paralelismo entre la educación personalizada y el yo cuantificado me parece muy acertado. También me lo parece la siguiente reflexión (vía Breves de La Vigi) de algunos de los stakeholders de la automonitorización.

In the QS world I’d like to live in, our personal data would be easily available to us to learn from using many different methods and tools. Here are some conditions I think would make this easier:

Data can be exported from the various systems we use into a simple format for exploration.

- We can store and backup our data using whatever method we want.

- We can share our data with whomever we want.

- We can rescind permission to look at our data.

- We can flow our data into diverse visualization templates and analytical systems.

I’ve tried to express these conditions briefly and simply, but any of them – and certainly all of them together – require changes in the systems we currently use, and these changes may be challenging for technical, business, social, and political reasons.

El tema es importante porque la actitud de propietario no se presta a una adaptación masiva (¿o acaso conocen alguna aplicación masiva de la Carta de Derechos de los Usuarios de la Web Social, que data de 2007?). No, la actitud de propietario la desarrolla cada persona desde dentro.